Estos ejemplos muestran cómo funciona Deep Fusion en los iPhone 11

Con iOS 13.2 y la llegada de Deep Fusion, toca analizar la mejora que esto supone a las cámaras de los nuevos iPhone 11 y 11 Pro.

Apple hizo gala de su nuevo modo Deep Fusion en la Keynote de lanzamiento de los nuevos iPhone el pasado Septiembre. Aunque nos explicaron en qué consistiría no nos hablaron ni de las limitaciones, ni de en qué escenarios íbamos a ser conscientes de este modo. Bien pues, casi dos meses más tarde y con iOS 13.2 lanzado oficialmente, desde Gizmodo UK han hecho una comparativa de como era la cámara del iPhone 11 Pro antes del modo Deep Fusion y como es ahora, ya con el dispositivo actualizado a la última versión y este modo funcionando.

Pongamonos en contexto, ¿cómo funciona Deep Fusion?

Explicándolo para todos los públicos, los iPhone toman varias capturas (9 para ser exactos) de la escena que queremos fotografiar, cada una con unas mediciones y ajustes para captar entre todas el mayor detalle posible gracias a las variaciones de la exposición, y luego el Neural Engine se encarga de fusionarlas aprovechando lo mejor de cada una y creando una imagen con un detalle superior.

Te puede interesar | Cómo usar Deep Fusion en los iPhone 11 y 11 Pro

Ahora toca detallar la parte "oscura" de esto, Deep Fusion no funciona con el ultra gran angular, y no podemos activarlo nosotros a nuestro antojo, es el iPhone el que según las condiciones de luz decide si la foto lo precisa. Según se sabe hasta el momento, utilizando el gran angular las fotos con iluminación media o tirando a pobre lo activan, y prácticamente todas las fotos con el telefoto, exceptuando aquellas con mucha iluminación, también. Debemos de tener en cuenta que si tenemos en nuestro iPhone el modo de captura de fotos fuera de encuadre, que es el que realiza una foto con el angular y otra con el ultra gran angular al mismo tiempo por si luego necesitamos corregirla, el modo Deep Fusion nunca se activará.

¿Es tanta la diferencia entre tener el modo Deep Fusion o no tenerlo?

La respuesta es depende de la circunstancia, veamos unos ejemplos y podremos valorar en que momentos Deep Fusion crea esas fotos más nítidas de las que Apple hablaba.

En esta primera imagen que han tomado para la comparativa desde Gizmodo UK, podemos ver como hay que prestar mucha atención para lograr ver la mejora. Tenemos que irnos a sutiles detalles de textura de la bandera de Estados Unidos, o a los bordes de los números del reloj para ver realmente una mejora en la fotografía.

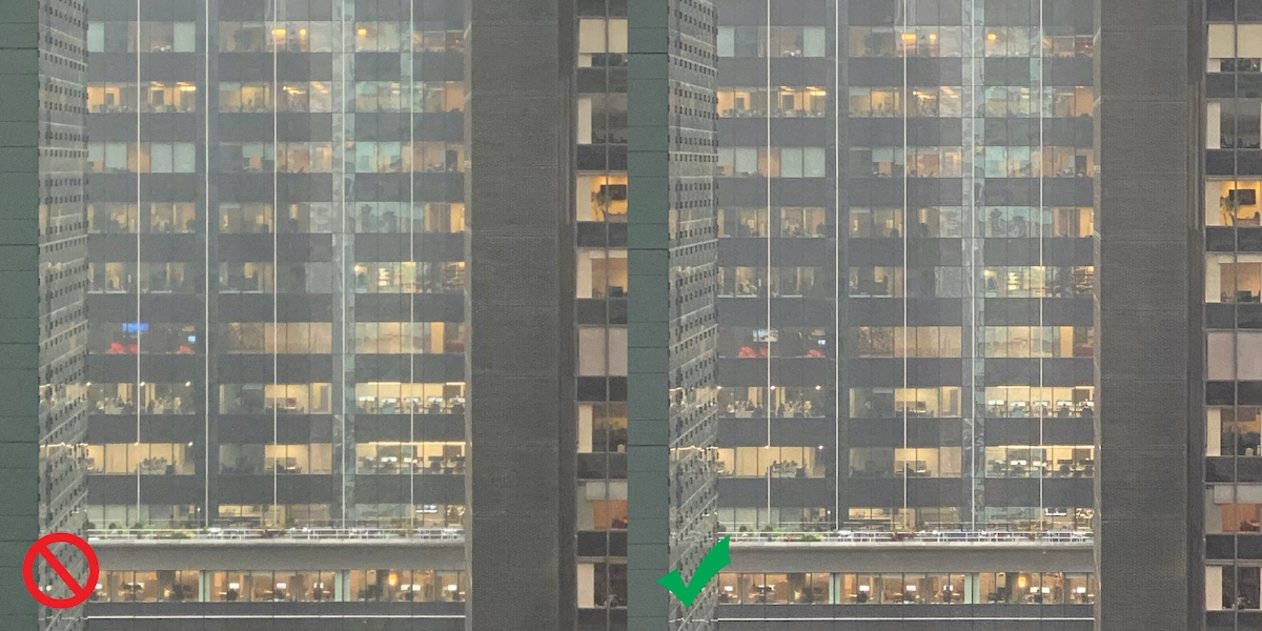

En esta segunda imagen aún debemos de mirar mas detalladamente para lograr ver la diferencia, y es que solo haciendo zoom somos capaces de lograr ver ese extra de nitidez del que hablaron en la presentación cuando se anunció Deep Fusión. Solamente cuando llegamos a la parte baja de la foto si miramos detalladamente el borde blanco de la terraza que aparece, podemos ver una mejora en lo que a definición se refiere. Hasta aquí la mejora que podemos ver gracias a Deep Fusion, si bien es verdad que existe, no justifica el bombo que recibió por parte de Apple durante la Keynote. Pasemos a una tercera foto con un tipo de detalle más exigente.

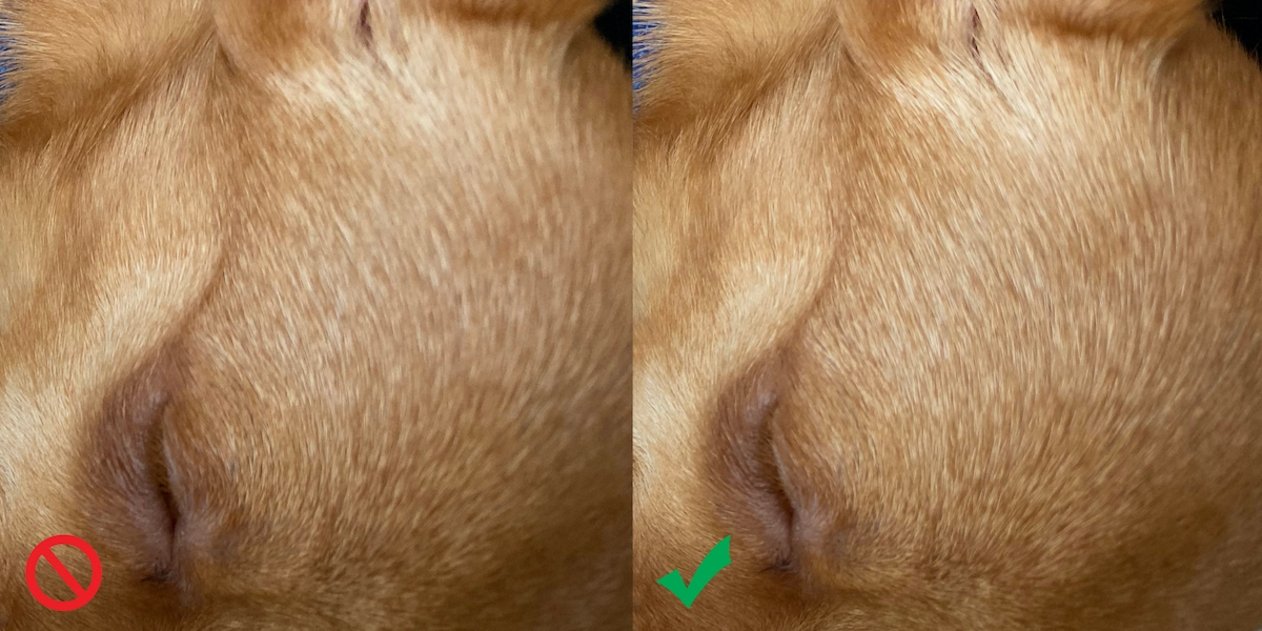

Ampliando sobre el pelaje del perro, podemos ver como la nitidez que ofrece es muy superior al iPhone sin, y es aquí donde sí que podemos ver claramente la mejora que ha introducido Deep Fusion, haciendo incluso que parezca carente de enfoque la foto realizada con el iPhone no actualizado. Recordemos que ambas están tomadas con el mismo dispositivo, uno actualizado y con este modo presente y otro sin.

Esto deja ver dónde destaca este Deep Fusion, y es en las texturas, donde consigue un detalle extra que marca la diferencia frente a lo que habíamos dispuesto hasta ahora.

Un primer paso de una tecnología aún con mucho desarrollo por delante.

Apple ha presentado un modo de alto detalle y nitidez, junto con una cámara sobresaliente en prácticamente todos los escenarios a los que podamos enfrentarnos en cuanto a fotografía móvil se trata. Ahora bien, tras ver los condicionantes y las circunstancias en las que Deep Fusion destaca, queda claro que esto es solo un primer paso en una tecnología que Apple aún puede evolucionar mucho y que seguro veremos con nuevas funciones en próximas versiones de iOS y nuevos dispositivos. Será entonces cuando se le pueda sacar todo el rendimiento a la fotografía computacional de nuestros dispositivos.

Puedes seguir a iPadizate en Facebook, WhatsApp, Twitter (X) o consultar nuestro canal de Telegram para estar al día con las últimas noticias de tecnología.