Apple va a analizar tus fotos, ¿qué pasa con la privacidad?

La nueva función de Apple para identificar fotos de posible abuso infantil es bastante polémica.

Apple ha anunciado una nueva tecnología destinada a detectar fotos de abuso infantil en las bibliotecas de fotos de iCloud de los usuarios. Es decir, Apple analizará las fotos que subimos a iCloud o que enviamos por iMessage en busca de fotografías que puedan estar relacionadas con el abuso infantil.

Siendo Apple una de las empresas que más se preocupa por la privacidad de los usuarios, una medida como esta puede poner en duda todo este esfuerzo. Sin embargo, la tecnología utilizada por Apple promete mantener la privacidad a salvo, a menos que se encuentren fotos de abuso infantil, Child Sexual Abuse Material en inglés, o CSAM.

Cómo detecta Apple CSAM, ¿atenta contra nuestra privacidad?

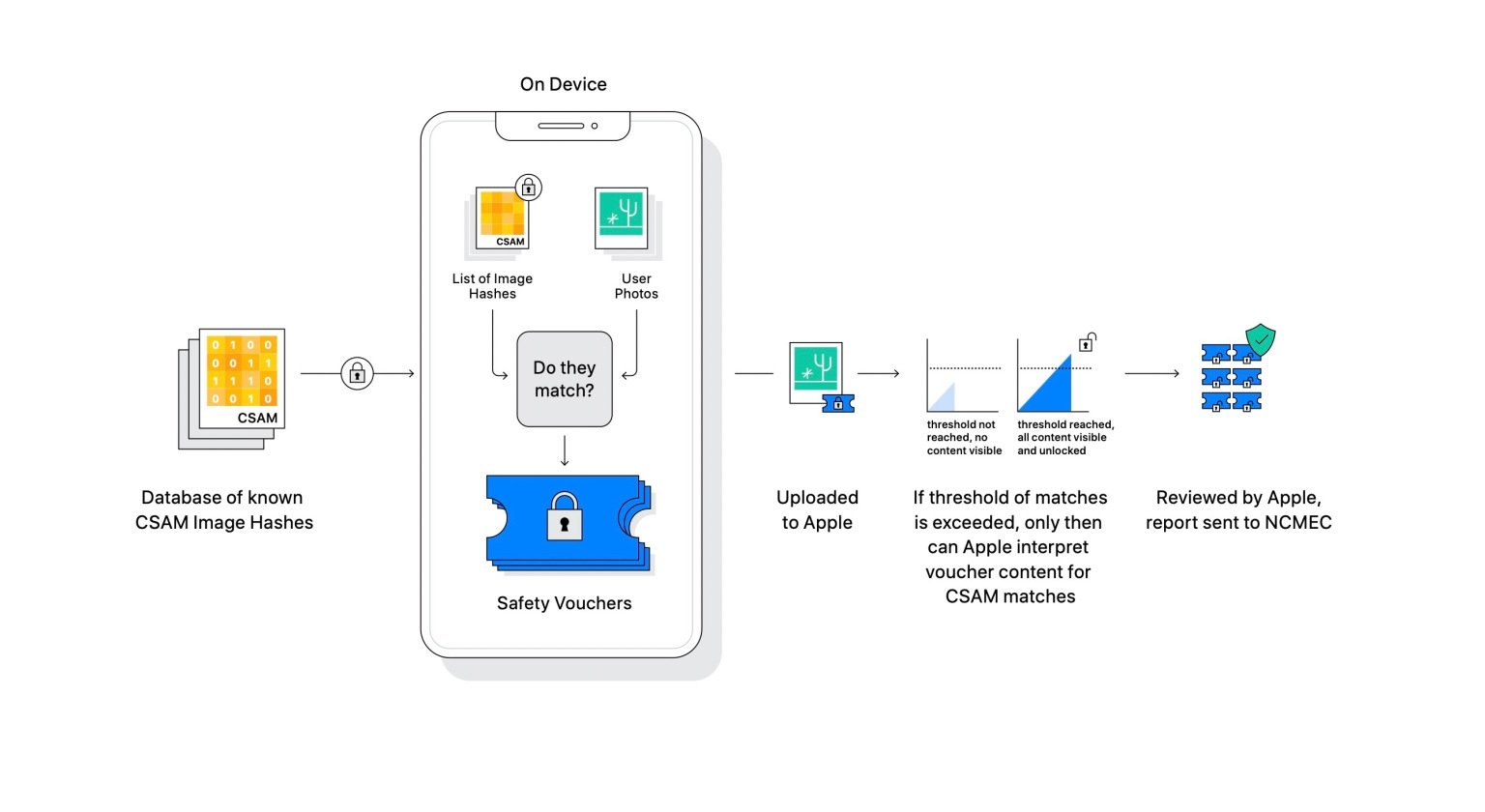

Apple describe que lo que esencialmente van a realizar es analizar las imágenes que se suban a iCloud y compararlas con una base de datos de imágenes conocidas de CSAM para ver si hay alguna coincidencia. Todo el proceso se realiza en el propio dispositivo, y Apple transforma las imágenes en hashes que se almacenan de forma segura nuestro dispositivo.

Una función criptográfica hash, conocida simplemente como “hash”, es un algoritmo matemático que transforma cualquier bloque de datos en una nueva serie de caracteres diferente. De forma que es imposible que Apple pueda ver tus imágenes, solo cuando salta una coincidencia Apple recibe el aviso y comprueba manualmente si existe una verdadera coincidencia, y en caso afirmativo lo pone en manos de las autoridades.

La detección se realiza a través del filtro de información y comparación de imágenes de una base de datos de CSAM y las bibliotecas del usuario.

Así es como explica Apple esta tecnología:

"Antes de que una imagen se almacene en Fotos de iCloud, se realiza un proceso de coincidencia en el dispositivo para esa imagen contra el conjunto ilegible de hashes CSAM conocidos. Este proceso de coincidencia está impulsado por una tecnología criptográfica llamada intersección de conjunto privado, que determina si hay una coincidencia sin revelar el resultado. La intersección de conjunto privado (PSI) permite a Apple saber si un hash de imagen coincide con los hashes de imagen CSAM conocidos, sin aprender nada sobre los hashes de imagen que no coinciden. PSI también impide que el usuario aprenda si hubo una coincidencia".

Es decir, nuestras fotos estarán a salvo y nadie podría verlas, a menos que nos encontremos con falsos positivos. Aunque Apple aseguró que tendría que haber varias imágenes que coincidan en la biblioteca del usuario para que se envíe el informe. Sin embargo, esto sigue teniendo otros riesgos.

El principal problema del sistema, del que se hace eco la Electronic Frontier Foundation, es que a fin de cuentas, Apple está abriendo una puerta trasera para escanear nuestro dispositivo antes de que nuestras fotos se envíen.

Fotos en el iPhone

Apple utiliza la base de datos con hashes a revisar de un tercero, usan el Child Sexual Abuse Material (CSAM) del National Center for Missing & Exploited Children. Pero igual en otros países, algunos gobiernos totalitarios pueden meter fotos diferentes para detectar disidentes o localizar manifestantes. A find e cuentas, por mucho que confiemos en Apple, los datos se obtienen de un tercero.

A pesar de estos posibles fallos, hay que decir que esta es una tecnología que lleva muchos años en uso en muchas plataformas de contenido. Quizás a algunos no les guste y otros piensen que es una buena media, pero que Apple debería haberla mantenido en secreto, ya que ahora estas personas están en sobreaviso.

Sea como sea, Apple parece estar orgullosa de su tecnología. En un memorando interno Sebastien Marineau-Mes, vicepresidente de software de Apple, se ha mostrado muy contento con esta novedad que llegará a fi ales de año.

"Mantener a los niños seguros es una misión muy importante. A la manera de Apple, perseguir este objetivo ha requerido un profundo compromiso multifuncional, que abarca Ingeniería, GA, HI, Legal, Marketing de Productos y Relaciones Públicas. Lo que anunciamos hoy es el producto de esta increíble colaboración, que ofrece herramientas para proteger a los niños, pero también mantener el profundo compromiso de Apple con la privacidad del usuario".

Este tipo de acciones son difíciles de valorar, y no hay una forma realmente correcta de hacer las cosas. Sin embargo es de aplaudir que Apple intente ayudar contra el abuso infantil a la vez que no compromete la privacidad de sus usuarios.

Puedes seguir a iPadizate en Facebook, WhatsApp, Twitter (X) o consultar nuestro canal de Telegram para estar al día con las últimas noticias de tecnología.