Apple anuncia tecnología capaz de detectar fotos de abuso infantil en las bibliotecas de los usuarios

Apple anuncia nuevas funciones para sus dispositivos que ayudan a combatir el abuso infantil.

Apple sigue trabajando en la seguridad, y recientemente se ha dado a conocer un nuevo sistema para la detección de material con aspectos de abuso infantil.

Apple contra el abuso infantil

De acuerdo a un reporte mencionado hace, Apple anunciaría una nueva herramienta con algoritmos hash para la detección fotográfica de contenidos relacionados al abuso infantil. Todo esto a través de un nuevo sistema que se instalaría en el dispositivo del usuario y que compararía las imágenes con material ilegal para encontrar coincidencias.

Este nuevo sistema trabajaría a traves de huellas digitales que no incumplen con las reglas de privacidad trabajadas actualmente por la compañía y que intervendrían en la subida de archivos a iCloud Photos con la finalidad de evitar la propagación y resguardo de material indebido.

Ahora es una realidad. De manera oficial la compañía Apple ha anunciado una nueva iniciativa para la protección de niños en iPhone, iPad y Mac. Con la frase: "proteger a los niños es una responsabilidad importante". Apple anuncia 3 novedades en función para este nuevo avance en seguridad.

Detección de CSAM

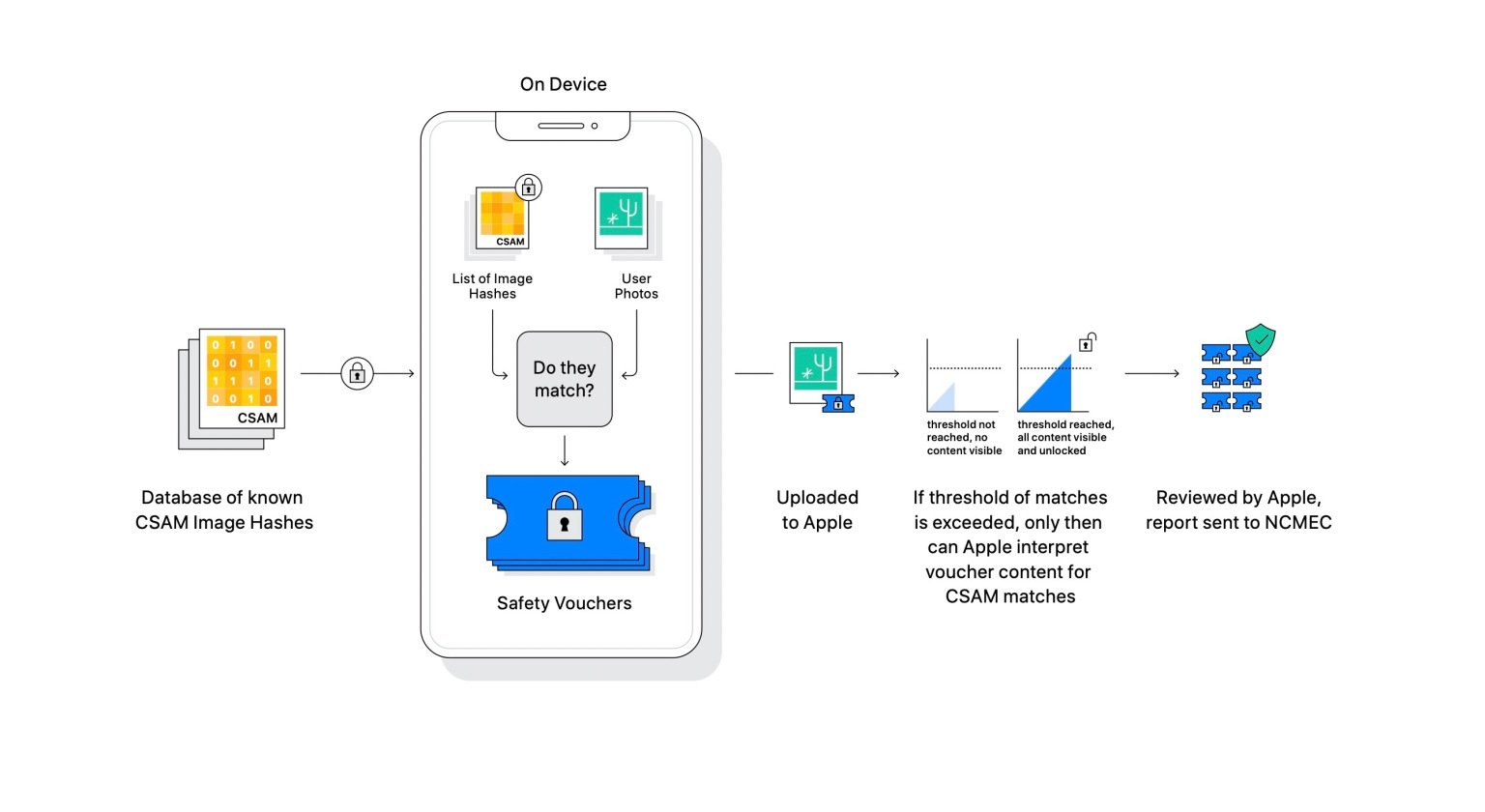

Con CSAM Apple se refiere al contenido que muestra actividades sexualmente explícitas que involucran a un niño. Para ello ha implementado un nuevo método de reconocimiento para el contenido del usuario con el fin de encontrar coincidencias a través del proceso de hashes mencionado anteriormente y así poder reportar casos de CSAM al Centro Nacional para Niños Desaparecidos y Explotados.

"Antes de que una imagen se almacene en Fotos de iCloud, se realiza un proceso de comparación en el dispositivo para esa imagen con el conjunto ilegible de hashes CSAM conocidos. Este proceso de coincidencia está impulsado por una tecnología criptográfica llamada intersección de conjuntos privados, que determina si hay una coincidencia sin revelar el resultado. La intersección de conjuntos privados (PSI) permite a Apple saber si un hash de imagen coincide con los hash de imagen CSAM conocidos, sin aprender nada sobre los hash de imagen que no coinciden. PSI también evita que el usuario sepa si hubo una coincidencia.

Para que no exista error, Apple hace uso de una nueva tecnología nombrada Umbral, la cual filtra y se asegura de que la detección sea correcta y no se pueda crear un falso hallazgo de CSAM. De acuerdo con los datos de Apple, el sistema tiene una tasa de error de menos de 1 en 1 billón de cuentas por año.

La detección se realiza a través del filtro de información y comparación de imágenes de una base de datos de CSAM y las bibliotecas del usuario.

Mensajes

Una de las novedades más importantes para la seguridad de menores llega con los mensajes. Ahora los niños que cuenten con dispositivos Apple ligados a una familia por medio de iCloud tendrán avisos de advertencia en sus mensajes al recibir o enviar alguna imagen que pueda ser sexualmente explícita.

Así es, cada que un menor reciba una imagen que pueda ser sensible, aparecerá borrosa y la app mandará una notificación de advertencia de inmediato. En esta advertencia se anunciará al menor porqué es indebida y en caso de acceder a verla el padre de familia de iCloud recibirá una notificación "para asegurarse de que estás bien".

Lo mismo sucederá cuando el menor intente enviar una foto considerada indebida por ser sexualmente explícita.

Apple hace mención de que el sistema comienza un aprendizaje automático que ayuda a determinar los contenidos sensibles sin necesidad de romper el acuerdo de cifrado de extremo a extremo con el que cuenta el servicio, por lo cual las conversaciones seguirán siendo privadas, pero más seguras para los niños.

Los padres podrán tener más control sobre sus hijos a través de la familia en iCloud.

Búsquedas y Siri

Finalmente las funciones de Siri y búsqueda de los dispositivos Apple han sido adaptados para ofrecer ayuda sobre el tema de abuso infantil.

"Apple también está ampliando la orientación en Siri y Search al proporcionar recursos adicionales para ayudar a los niños y padres a mantenerse seguros en línea y obtener ayuda en situaciones inseguras. Por ejemplo, los usuarios que le pregunten a Siri cómo pueden denunciar el abuso sexual infantil o infantil o la explotación infantil serán dirigidos a recursos sobre dónde y cómo presentar una denuncia.

Siri y Search también se están actualizando para intervenir cuando los usuarios realizan búsquedas de consultas relacionadas con CSAM. Estas intervenciones explicarán a los usuarios que el interés en este tema es dañino y problemático, y proporcionarán recursos de los socios para obtener ayuda con este tema.

Siri y la función de búsqueda también ofrecerán ayuda e información sobre el abuso infantil.

Estas novedades se implementarán en las actualizaciones de iOS 15, iPadOS 15 y macOS Monterey, comenzarán en Estados Unidos y se expandirá lo más pronto posible a otras regiones.

No hay duda de que este es un gran paso para el bienestar social, para el control y cuidado de los menores que utilizan dispositivos y algo que de manera desinteresada podría repercutir para el éxito de Apple que hoy en día se ha vuelto la sexta compañía que más gana dinero en la actualidad.

Puedes seguir a iPadizate en Facebook, WhatsApp, Twitter (X) o consultar nuestro canal de Telegram para estar al día con las últimas noticias de tecnología.