El que más sabe sobre inteligencia artificial lo deja claro: "Creo que algo malo va a pasar con la IA"

Sam Altman se muestra consciente de lo mal que puede irnos si utilizamos la IA para ciertos fines, los deepfakes y los vídeos hechos con Sora es el inicio de ello

Sam Altman es uno de los directivos más conscientes sobre el impacto que la IA puede representar a la vida de cada uno de nosotros. Sus recientes declaraciones para un podcast son muestra de ello. A pesar que está a cargo de OpenAI, una de las empresas más poderosas de inteligencia artificial, sabe los límites a los que se enfrenta y ha dejado una cosa en claro, no estamos libres de la maldad. Los deepfakes forman parte de ello.

La tecnología ha llegado a un punto en el cual podrían ocurrir cosas malas, según Sam Altman

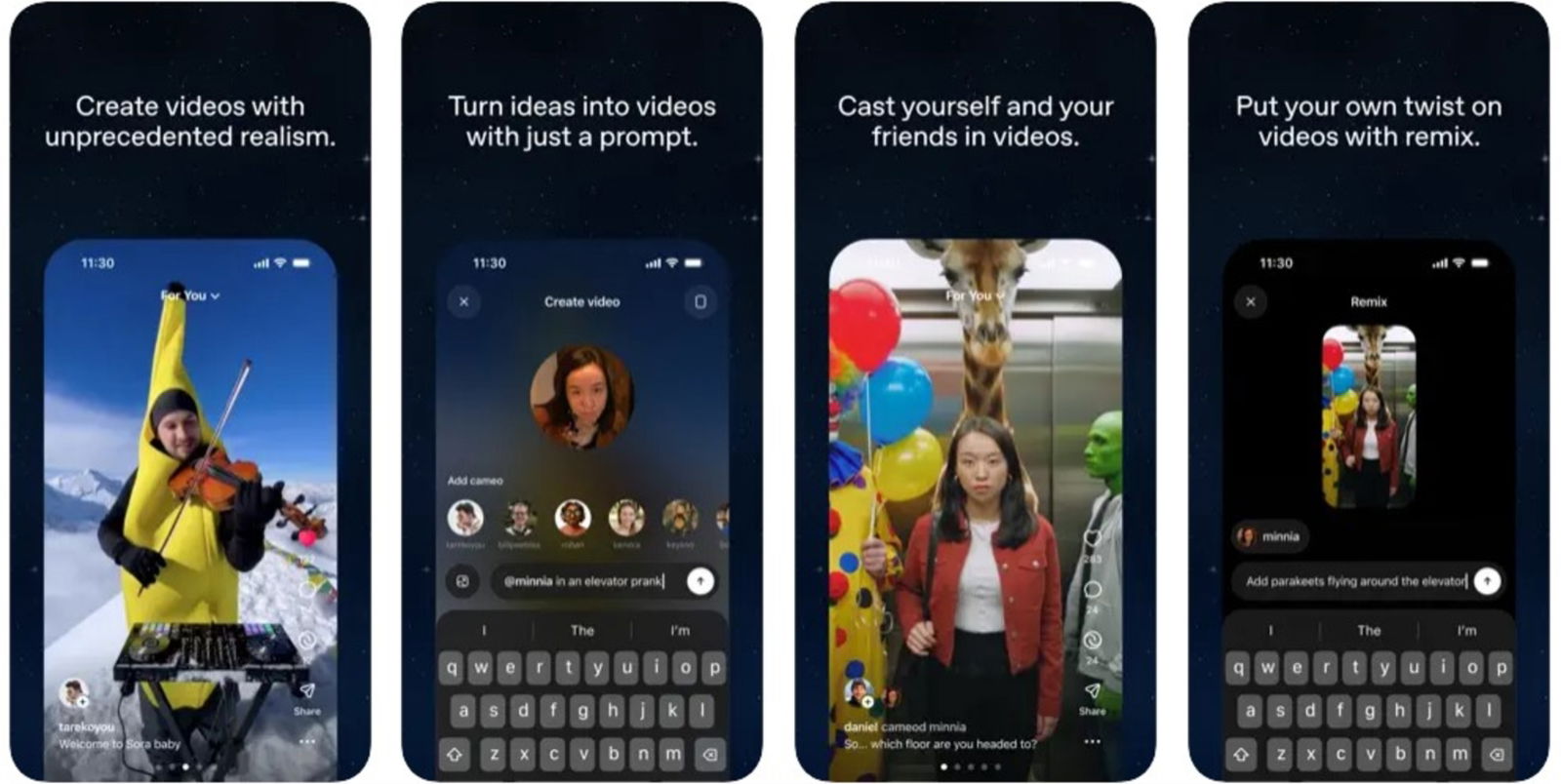

La firma de capital de riesgo Andreessen Horowitz tiene un podcast de título "a16z" donde Sam Altman, CEO de OpenAI, pudo expresar estas declaraciones interesantes. Todo viene a raíz de lo que puede hacer la nueva actualización de Sora, la app que se ha vuelto viral por los contenidos vistos en distintas redes sociales. Se colocó de inmediato en el primer puesto de la App Store. Lo que fue inquietante fue la manera en la que los usuarios la hicieron viral, los deepfakes tanto de gente fallecida como de famosos, igualmente el propio Altman se vio involucrado en estos vídeos.

Es de cuestionarse el porqué lanzan este tipo de creaciones pero no es nada más que la evolución de la tecnología. Si Sora no lo hace, alguien más lo hará y se llevará el crédito por eso mismo. Altman se justifica diciendo que tienen que seguir adelante, más que nada "porque la sociedad necesita una prueba".

Sam Altman en el podcast a16z

Muy pronto el mundo tendrá que lidiar con increíbles modelos de vídeo que pueden falsificar cualquier imagen o mostrar prácticamente cualquier cosa que se quiera.

Lo que debe suceder, en voz del propio Altman, es una "coevolución" entre la sociedad y la IA en algo que simplemente "ya no se puede abandonar". La tecnología ya es de dominio público y la única forma es "establecer límites y normas" antes de que las herramientas muten a algo más poderoso.

¿Cuáles son los siguientes pasos en este caso?

Sigo pensando que habrá momentos realmente extraños o aterradores. No significa que nunca lo hará (respecto a que la IA no ha causado un evento horripilante). Miles de millones de personas hablando con el mismo cerebro podrían crear cosas extrañas a escala social.

La app Sora de OpenAI ya esta disponible

Está de acuerdo en apoyar cualquier tipo de prueba de seguridad rigurosa para los modelos futuros que puedan exponerse para aplicarse en la IA, sea en vídeos o cualquier material. No tiene que ser necesariamente un deepfake, sino que la IA va a ser utilizada para casi cualquier cosa y que muchos podrían no comprender a los algoritmos de propias decisiones, algo que podría caer como una actitud inconsciente.

Sobre el tema de futuras regulaciones indicó que la mayoría de ellas podrían tener desventajas. En este caso deberían aplicarse por igual y a cada una de las inteligencias artificiales, al menos con los adolescentes está ocurriendo a tal grado que son monitoreados de las actividades que realizan. Existe un límite entre la privacidad y el libre albedrío, usar la IA para la productividad o el ocio es el ejemplo perfecto. ¿Qué tanto deliberas a la IA en tu vida diaria? ¿Piensas que podrías deliberarla a tal grado de solo ordenarle cosas mientras solo te dedicas a ver lo que hace?

Puedes seguir a iPadizate en Facebook, WhatsApp, Twitter (X) o consultar nuestro canal de Telegram para estar al día con las últimas noticias de tecnología.