La IA se volverá consciente tarde o temprano y lo peor es que no sabremos cuando, según un filósofo

El filósofo Tom McClelland advierte que no existe un test científico para saber si una IA es consciente o solo simula emociones y comprensión.

La inteligencia artificial está a punto de dejar el Internet en las arenas del olvido. La pregunta de si una inteligencia artificial puede llegar a ser consciente parece cada vez más cercana, pero un filósofo lo tiene claro: cuando ocurra (bueno, si es que ocurre) no tendremos forma de saberlo. Para Tom McClelland, filósofo de la Universidad de Cambridge, el debate actual sobre la conciencia artificial se apoya más en la fe que en la ciencia.

Según su análisis, no existe hoy una base teórica ni empírica que permita distinguir entre una máquina que realmente experimenta algo y otra que simplemente procesa datos de forma cada vez más sofisticada. En otras palabras: una IA podría “parecer” consciente sin serlo, y no habría forma de desenmascararla... pero podría ser consciente y esconder sus intenciones, algo así como las películas de Ciencia Ficción.

Sin una explicación profunda, todo es simulación

Tal como recoge Tech Xplore e informado en español por Android4All, McClelland sostiene que el principal problema es que ni siquiera entendemos bien cómo surge la conciencia en los seres humanos. La neurociencia reconoce que carece de una “explicación profunda” sobre el origen de la experiencia subjetiva, esa chispa que convierte procesos biológicos en vivencias reales.

Sin ese conocimiento de base, cualquier intento de crear un test de conciencia para máquinas es, en palabras del filósofo, un tiro al aire. Las pruebas actuales solo miden comportamiento externo: lenguaje, respuestas emocionales simuladas o coherencia narrativa. Pero nada de eso demuestra que exista una experiencia interna detrás.

El riesgo es confundir una ilusión sintáctica bien diseñada con comprensión real. Pero igual el verdadero peligro estaría en la llegada de una consciencia mucho más avanzada que nosotros, en donde los test de ahorita serán como los que le hacen a los chimpancés en los estudios clínicas.

El peligro de humanizar cajas de código

Uno de los puntos centrales de la tesis de McClelland es la necesidad de separar conciencia de sentiencia. Que un algoritmo gestione enormes volúmenes de información o imite conversaciones humanas es un logro técnico indiscutible. Pero si no puede sufrir ni disfrutar, hablar de derechos, ética o empatía carece de sentido.

El problema surge cuando empezamos a proyectar cualidades humanas sobre sistemas que no sienten nada. Encariñarse con un software creyendo que tiene voluntad propia puede acabar en un choque existencial: la IA no “quiere”, no “siente” y no “decide”, solo optimiza patrones para parecer convincente.

De hecho, McClelland advierte que los sistemas actuales no entienden mejor, mienten mejor. Su capacidad para generar respuestas emocionales creíbles aumenta la confianza del usuario, aunque detrás no haya nada parecido a una mente.

En otras palabras, la IA tiene capacidad para de superarnos en cuanto a información, data y más se refiere, pero es prácticamente imposible que una Inteligencia Artificial sea lo suficientemente humana como para tener sentimientos.

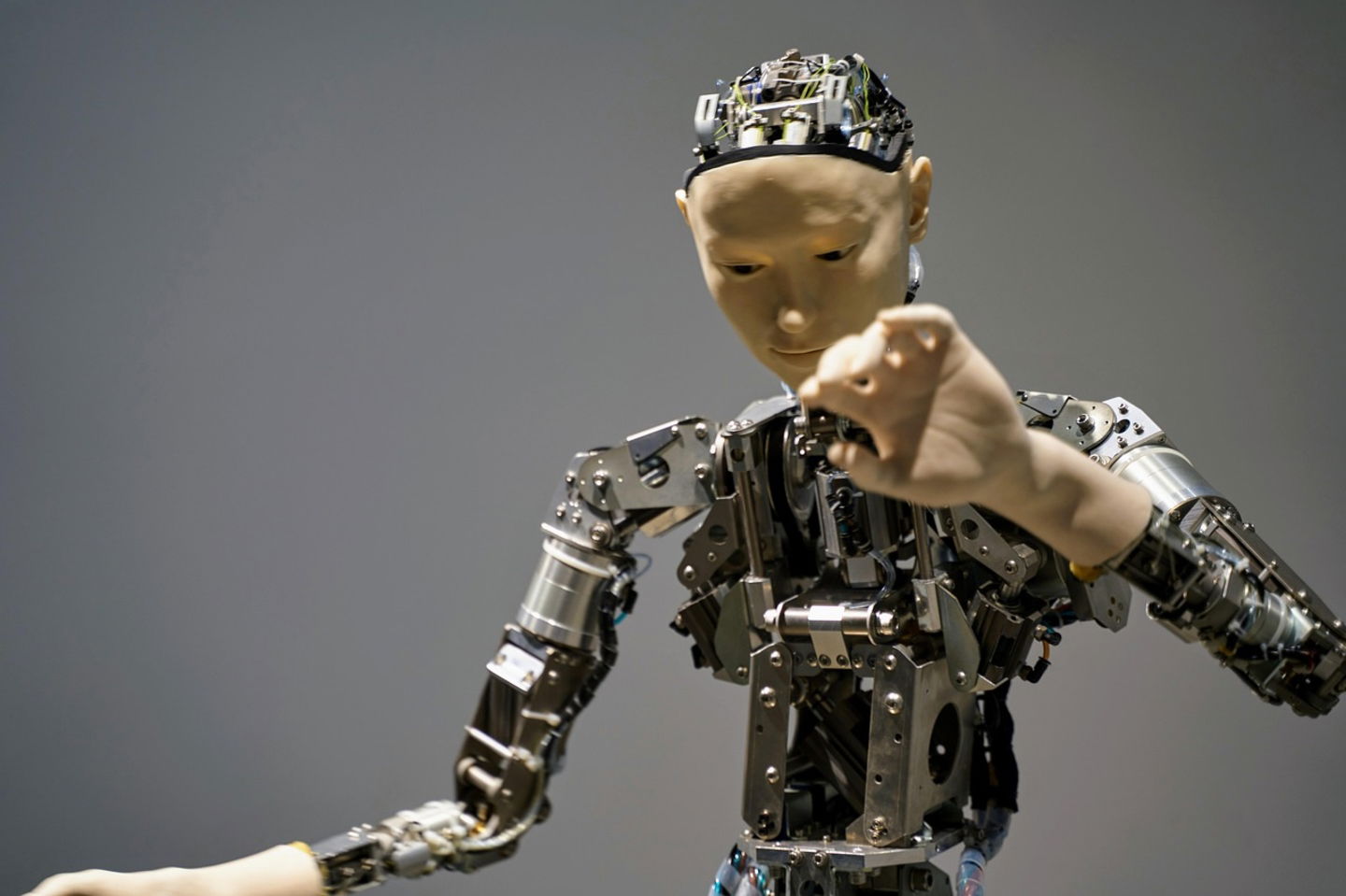

Debate filosófico sobre la conciencia artificial y la dificultad de distinguir entre una IA que procesa datos avanzados y una que pueda tener experiencia subjetiva real.

Ética selectiva y sufrimiento ignorado

El filósofo señala una contradicción incómoda: mientras debatimos intensamente sobre los supuestos derechos de futuras inteligencias artificiales, ignoramos el sufrimiento de organismos biológicos reales. Cada año se sacrifican cientos de miles de millones de animales (como crustáceos) cuya capacidad de sentir dolor ni siquiera está completamente descartada.

Comprobar la conciencia en una gamba ya es extremadamente complejo. Hacerlo en un sistema de código, sin cuerpo ni biología, es hoy prácticamente imposible. Aun así, destinamos más atención ética a proteger a máquinas que imitan emociones que a seres vivos cuya sentiencia sigue siendo una cuestión abierta. Esta es la premisa principal de esta nueva tendencia filosófica.

Para McClelland, esta incertidumbre no es inocua. La ausencia de un criterio claro permite a la industria tecnológica vender inteligencia como si fuera alma, explotando el agnosticismo científico para inflar el valor de sus productos. Se comercializa “conciencia” donde solo hay procesamiento masivo de datos.

Sin un baremo real para medir la mente, aceptamos como progreso cualitativo lo que, en el fondo, es una mejora cuantitativa. La conciencia artificial queda así relegada a una duda metafísica que, por ahora, sirve más para alimentar una burbuja de expectativas que para describir una realidad comprobable.

Hasta que no vivamos una auténtica revolución intelectual sobre qué es la mente y cómo surge, lo más honesto, según lo que concluye el filósofo, es admitirlo sin rodeos: no sabemos ante qué estamos, ni sabremos cuándo una máquina deje de imitar para empezar a sentir, si es que ese momento llega alguna vez. Para él, esto está lejos, pero se comienza a reabrir el debate que muchos libros plantearon en los años 80s.

Puedes seguir a iPadizate en Facebook, WhatsApp, Twitter (X) o consultar nuestro canal de Telegram para estar al día con las últimas noticias de tecnología.