Apple presenta ReALM, un modelo de IA más pequeño y rápido que GPT-4

El nuevo modelo de lenguaje de inteligencia artificial de Apple será anunciado al mundo durante la WWDC de 2024

Últimamente han salido a la luz muchos rumores sobre cómo se plantea Apple la introducción de la inteligencia artificial en su ecosistema de productos. Se aseguraba que Apple estaba trabajando en novedades de IA generativa con un modelo de lenguaje basado en Ajax. Ahora la firma de Cupertino ha presentado su propia IA: ReALM.

La noticia ha llegado poco después de que se revelase que Apple podría asociarse con Google para integrar Gemini en iOS 18 y haya mantenido conversaciones con OpenAI, los creadores de ChatGPT. Asimismo, la compañía californiana también ha adquirido una serie de startups relacionadas con la industria de la inteligencia artificial.

Sea como fuere, el modelo de lenguaje ReALM de Apple ya ha sido presentado por sus desarrolladores. Y según la compañía, es más rápido y eficiente que ChatGPT en algunas operaciones.

ReALM: todo lo que necesitas saber sobre la IA de Apple

Todo apunta a que ReALM será presentado oficialmente durante la WWDC 2024 en junio. El nuevo modelo de lenguaje ha sido revelado al mundo en exclusiva por VentureBeat y ha sido bautizado como ReALM – Resolución de Referencia Como Modelo de Lenguaje por sus siglas en inglés.

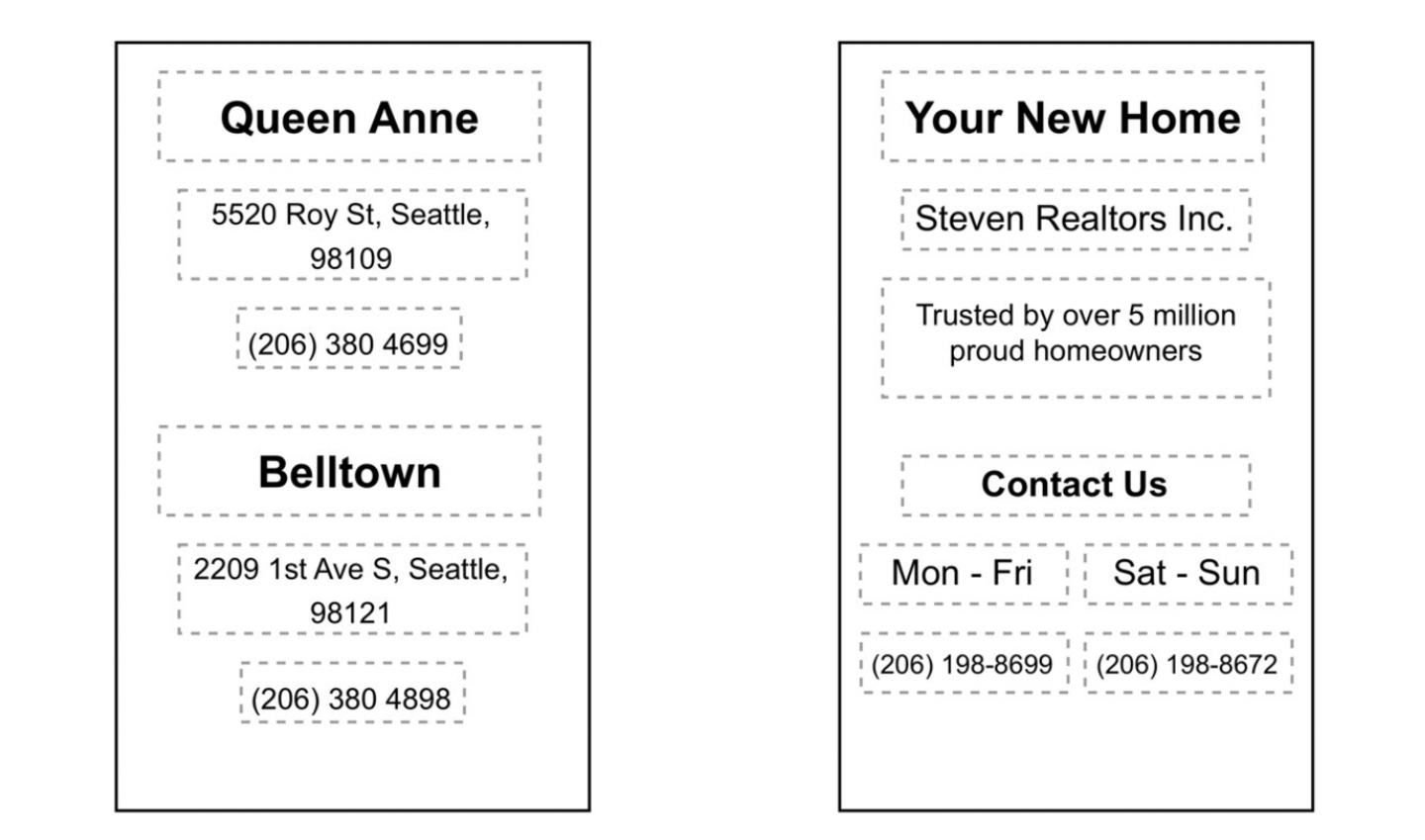

El nuevo sistema de inteligencia artificial de Apple es capaz de comprender el contexto de diferentes referencias de elementos visuales en una pantalla, convertir imágenes en texto y producir interacciones más naturales y conversacionales con un asistente de voz.

El equipo de investigación de IA de Apple ha asegurado que ReALM es más rápido y eficiente que GPT-4 en la asimilación de datos contextuales. Además, han querido dar a conocer algunas de las pautas básicas en el desarrollo de su modelo de lenguaje.

"Ser capaz de comprender contexto, incluyendo referencias, es esencial para un asistente conversacional. Habilitar que el usuario pregunte cuestiones sobre lo que ven en su pantalla es un paso crucial para asegurar una experiencia de manos libres en los asistentes de voz."

Los ordenadores no pueden interpretar las imágenes de la misma forma en la que lo hace un humano. Pero Apple ha encontrado la solución con su modelo de lenguaje ReALM, reconstruyendo todo el contexto de una pantalla en texto.

Representación de obtención de datos de texto en una imagen

ReALM ofrece un rendimiento similar a GPT-4 usando muchos menos parámetros. Y es más eficiente al incrementar sus parámetros.

"Hemos demostrado grandes mejoras sobre un sistema existente con funcionalidad similar a través de diferentes tipos de referencias, con nuestro pequeño modelo obteniendo mejoras del 5% en referencias en pantalla. Nuestros modelos más grandes tienen un rendimiento sustancialmente mejor que GPT-4."

Aunque todavía queda mucho trabajo por delante. ReALM tiene sus limitaciones a la hora de gestionar referencias visuales más complejas, como distinguir entre múltiples imágenes.

La inteligencia artificial ha resurgido con mucha fuerza a lo largo de los últimos meses, concretamente desde la presentación de ChatGPT en la búsqueda de Bing por parte de Microsoft. Desde entonces, todas las compañías de tecnología compiten por desarrollar el modelo de lenguaje más avanzado. Una carrera de IA a la que Apple por fin se ha sumado. Aunque Tim Cook ha señalado en una entrevista con Dua Lipa que Apple ya había implementado muchas funciones de IA en el iPhone y en otros dispositivos.

"Si eres un cliente de Apple hoy, la IA está en todos los productos que producimos de una forma muy significativa, pero no la etiquetamos como tal."

La IA del modelo de lenguaje ReALM tiene muy buena pinta y hará que Siri y otros elementos de los sistemas operativos de Apple ofrezcan grandes beneficios a los usuarios. ¿Qué te parece esta interesante novedad sobre Apple?

Puedes seguir a iPadizate en Facebook, WhatsApp, Twitter (X) o consultar nuestro canal de Telegram para estar al día con las últimas noticias de tecnología.