Apple retrasa el escaneo CSAM de las fotos de iCloud

Apple ha decidido dar marcha atrás con el escaneo de las fotos en busca de abusos infantiles.

Apple acaba de anunciar que su polémico escaneo de las fotos de iCloud en búsqueda de posibles abusos infantiles se retrasa y que "tomarán un tiempo adicional" para mejorar la tecnología antes de lanzarla al público. En una declaración a 9to5Mac, representantes de la compañía han desvelado este retraso en una herramienta que se presentó hace solo unas semanas.

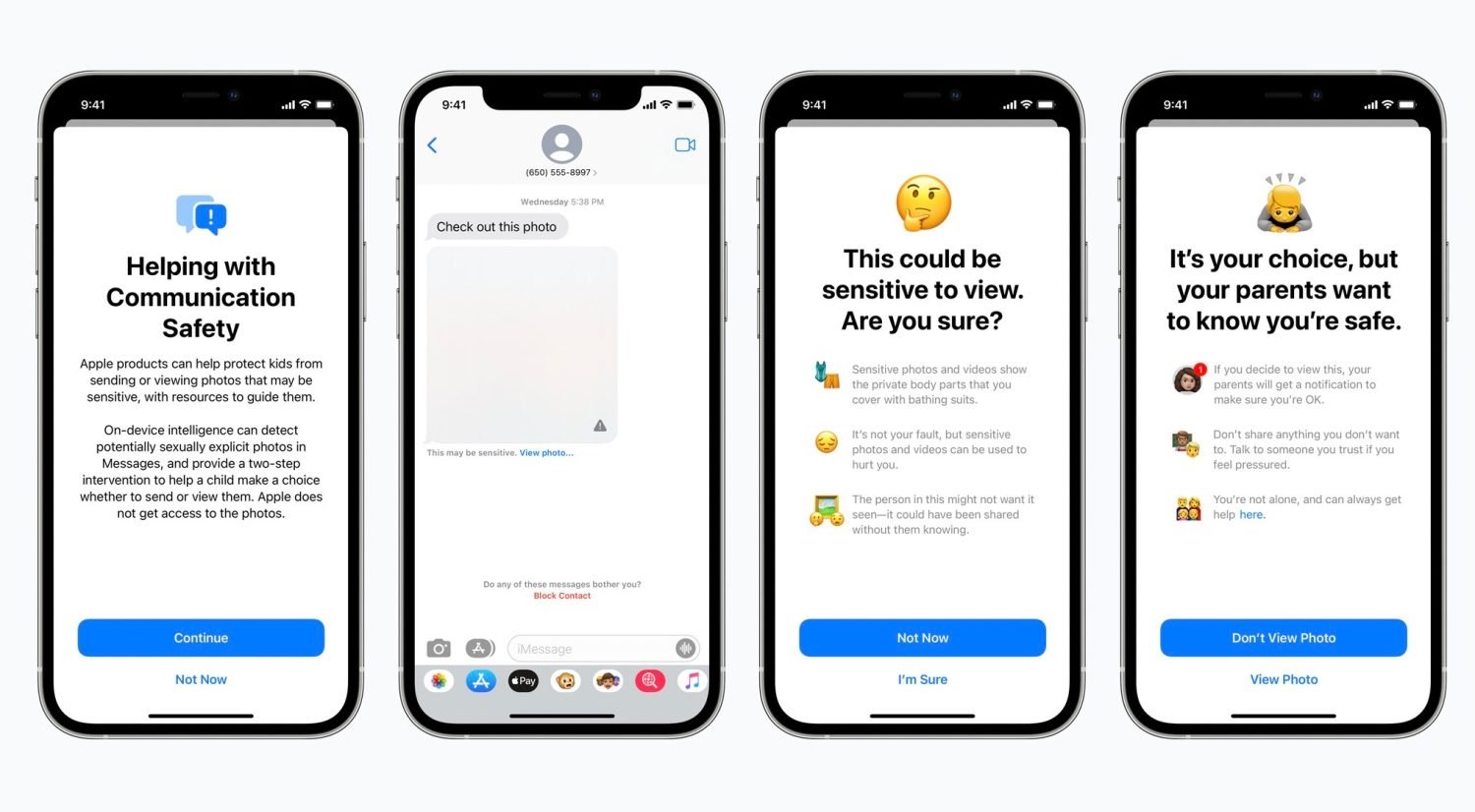

Apple anunció esta función a principios de agosto y estaba destinada a proteger a los niños de posibles depredadores que usaran dispositivos de Apple para encontrarlos, todo teniendo en cuenta la privacidad de los usuarios. Sin embargo es una función que muchos usuarios y expertos criticaron. Y parece que con razón ya que ahora Apple ha decidido retrasar esta novedad hasta mejorar la tecnología.

"El mes pasado anunciamos planes de características destinadas a ayudar a proteger a los niños de los depredadores que utilizan herramientas de comunicación para reclutarlos y explotarlos, y limitar la propagación del Material de Abuso Sexual Infantil. Basándonos en los comentarios de los clientes, grupos de defensa, investigadores y otros, hemos decidido tomarnos un tiempo adicional en los próximos meses para recopilar información y hacer mejoras antes de lanzar estas características de seguridad infantil de importancia crítica".

Los planes de Apple eran lanzar esta función en iOS 15, iPadOS 15 y macOS Monterey a finales de este año, pero ahora no se ha anunciado una nueva fecha. Por lo tanto, no sabemos cuándo se implementará esta función, ni qué mejoras va a incluir exactamente Apple.

Apple anuncia nuevas funciones CSAM contra el abuso infantil.

Básicamente, así es como Apple definió esta función:

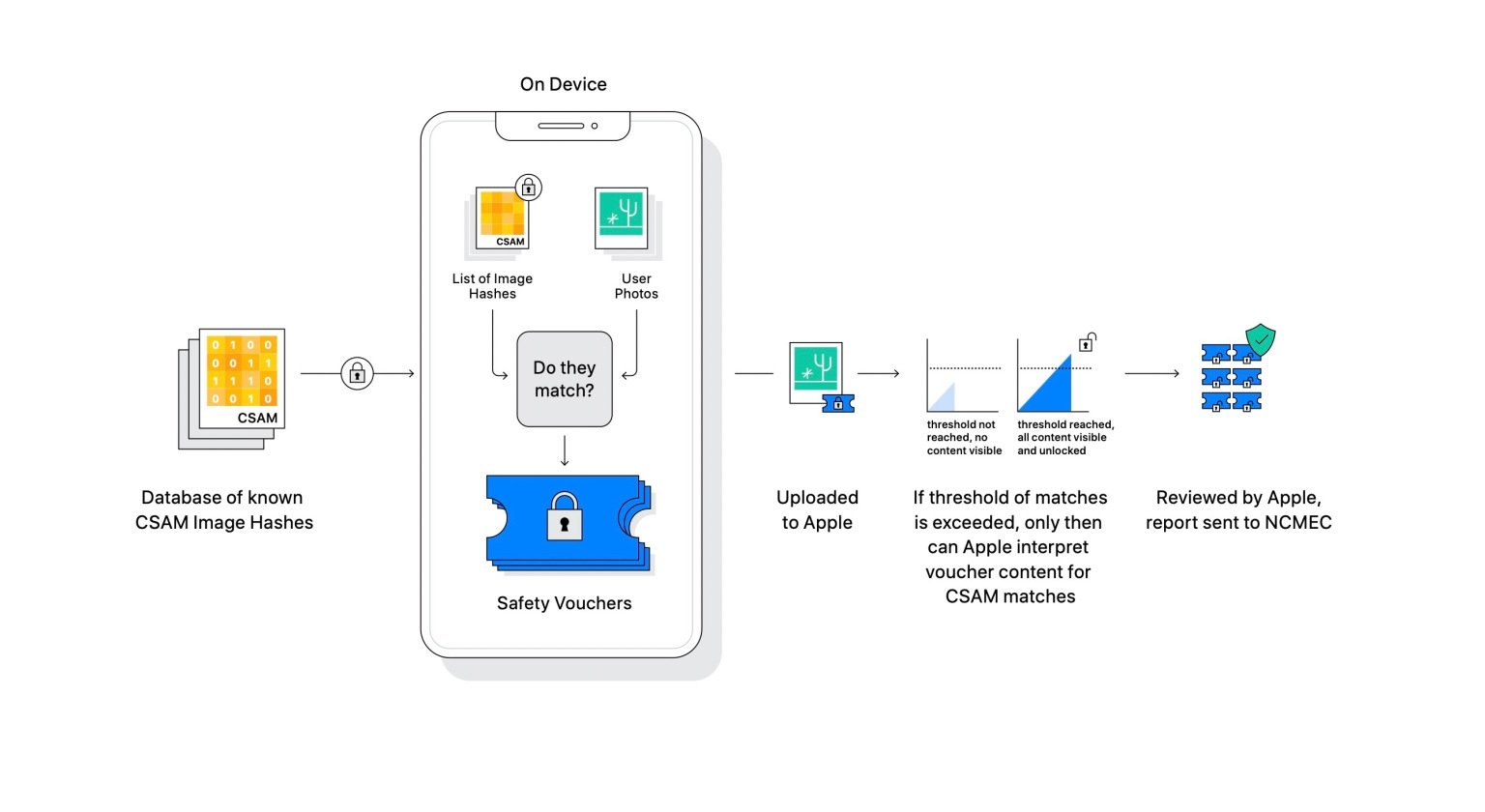

"El método de Apple para detectar CSAM (Child Sexual Abuse Material) está diseñado teniendo en cuenta la privacidad del usuario. En lugar de escanear imágenes en la nube, el sistema realiza la comparación en el dispositivo utilizando una base de datos de hashes de imágenes CSAM conocidos proporcionados por NCMEC y otras organizaciones de seguridad infantil. Apple transforma aún más esta base de datos en un conjunto ilegible de hashes que se almacena de forma segura en los dispositivos de los usuarios".

"Antes de que una imagen se almacene en Fotos de iCloud, se realiza un proceso de coincidencia en el dispositivo para esa imagen contra los hashes CSAM conocidos. Este proceso de coincidencia está impulsado por una tecnología criptográfica llamada intersección de conjunto privado, que determina si hay una coincidencia sin revelar el resultado. El dispositivo crea un vale de seguridad criptográfico que codifica el resultado de la coincidencia junto con datos cifrados adicionales sobre la imagen. Este vale se carga en Fotos de iCloud junto con la imagen".

La detección se realiza a través del filtro de información y comparación de imágenes de una base de datos de CSAM y las bibliotecas del usuario.

Veremos si a finales de año tenemos nuevas noticias sobre esta tecnología. Algo que, por cierto, se había convertido en uno de los principales motivos por los que los usuarios de Android no querían el iPhone 13.

Puedes seguir a iPadizate en Facebook, WhatsApp, Twitter (X) o consultar nuestro canal de Telegram para estar al día con las últimas noticias de tecnología.